El País ha publicado en su edición de este sábado un bochornoso artículo sobre el crecimiento de iglesias evangélicas en la zona de Carabanchel.

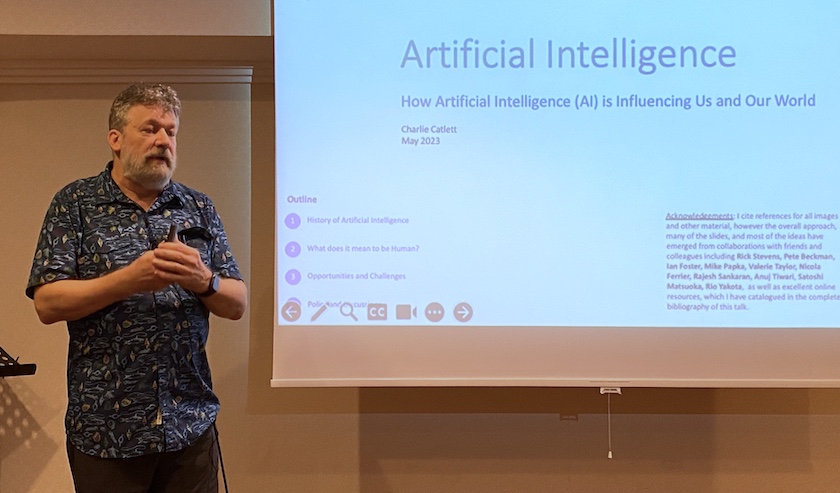

Charlie Catlett, experto en tecnología e Internet desde los años 80, explica las consecuencias de la irrupción de la inteligencia artificial, las bases de su funcionamiento y qué podemos esperar en el futuro con su uso masivo.

Charlie Catlett, ingeniero informático, fue uno de los ponentes en el European Leadership Forum celebrado en Polonia en mayo de 2023./ J.Forster

Charlie Catlett, ingeniero informático, fue uno de los ponentes en el European Leadership Forum celebrado en Polonia en mayo de 2023./ J.Forster

La IA es ya una realidad incuestionable y su impacto en el mundo de la comunicación, las finanzas o el arte se empieza a hacer notorio. Pero a la vez, aumentan las preguntas y la desconfianza por el desarrollo de una tecnología que podría, según han denunciado algunos expertos, escapar del control humano.

Charlie Catlett, un científico informático que participó en la construcción del primer Internet en la década de 1980, es uno de esos expertos que está reflexionando y dando formación sobre los aspectos técnicos detrás de herramientas como Chat GPT. A pesar de su alto perfil científico, es capaz de responder a las preguntas que nos hacemos de una manera amena y constructiva.

“Pensábamos que este nivel de inteligencia artifical no llegaría tan rápido, esto nos tomó a todos por sorpresa”, dijo a Evangelical Focus en una entrevista realizada en Polonia, durante el último European Leadership Forum, iniciativa anual que reúne a más de 800 líderes evangélicos de todo el continente.

Ante los avances que se están dando, Catlett recuerda que, para los cristianos, el control de todas las cosas sigue estando en manos de Dios.

Pueden ver la entrevista en inglés aquí o leer la transcripción al castellano debajo:

Pregunta. Estuviste involucrado en los orígenes de Internet en los años 80. ¿Qué es lo que más te fascina de su evolución hasta hoy?

Respuesta. Empecé a trabajar en Internet cuando en realidad era una pequeña actividad informática a mediados de los años 1980. Luego, cuando apareció la World Wide Web (WWW), estuve involucrado porque uno de mis equipos era responsable de los servidores web a los que iba el navegador Mosaic. Rápidamente llegamos a cientos de miles de usuarios y mi equipo estaba debatiendo cómo hacer crecer los servidores web para poder manejar ese tipo de carga.

Mientras reflexionaba sobre las diferencias actuales con respecto a nuestro concepto de Internet en la década de 1990, diría que pensábamos que nos entusiasmaba la World Wide Web porque significaba que cualquier persona con una conexión a Internet podía producir y difundir información. Sentimos que esto era algo bueno.

En aquel tiempo, la única manera de encontrar algo en la web era ir a algún sitio que hiciera búsquedas en la web, y esa web te mostraría las cosas en un orden relacionado con su popularidad. Entonces, digamos, si tu sitio web personal estuviera vinculado desde tu empresa, desde tu iglesia y desde tres de tus amigos, tendrías cinco enlaces a tu sitio web. Y si mi sitio web tuviera solo un enlace del sitio web de mi madre pero nada más, entonces solo tendría un enlace. Entonces, el motor de búsqueda diría: “mostremos primero tu sitio web y el mío podría estar en la página seis de los resultados”. La popularidad de la información se basó realmente en el mérito, ya que tenía que gustarme lo suficiente tu sitio como para modificar mi sitio para que apunte al tuyo.

[destacate]“Nos entusiasmaba dar forma a un sistema donde cualquier persona podía difundir información”[/destacate]Ahora, si avanzamos hasta el momento en que aparecieron las redes sociales, la forma en que se difundió esa información ya no se basaba en esta meritocracia del sistema inicial. Ahora se basaba en los algoritmos de Inteligencia Artificial que utilizan las redes sociales para decidir qué mostrar en sus noticias. Lo que las redes sociales aprendieron es que la manera de mantenerte interactuando con su sitio (que es como ganan dinero a través de los anuncios) es aprovechar tus emociones. Cuando estamos enojados, indignados, asustados o tristes, es más probable que leamos más y permanezcamos en el sitio web por más tiempo. Los algoritmos de “recomendación” cambiaron de una difusión basada en méritos a una amplificación no lineal. Si muchas personas hacen clic en una determinada historia porque les encanta el titular (porque es escandaloso, por ejemplo), de repente mucha más gente ve esa historia y puede crecer como una bola de nieve muy rápidamente, lo que llamamos “volverse viral”. Se trata de un efecto en el que ni siquiera hubiéramos pensado en los años noventa. Ahora muchos de nosotros los miramos y vemos que no encarnan ningún tipo de valor. Señalo éstas como una de las principales razones por las que vemos que la sociedad está cada vez más polarizada en torno a cuestiones sociales.

P. ¿Cómo ha reforzado el sesgo la Inteligencia Artificial (IA)?

R. Si te digo cómo funciona la IA desde el punto de vista de la informática, diré cosas como “son sólo matemáticas”, “es sólo probabilidad y estadística”, “no tiene valores”, y entonces sería correcto concluir que los sistemas de IA con los que estoy interactuando son imparciales. Pero luego viene el entrenamiento de los modelos de IA. Se toman millones de páginas de texto digital y se pasan por un modelo de lenguaje. Al digerir todo ese texto se identifican patrones y valores estadísticos. Enonces comienza a categorizar información asociando palabras y conceptos.

Imaginemos que entrenas el modelo de IA con un texto en el que cada vez que ves a una enfermera siempre es una mujer. La palabra ‘enfermera’ y el concepto de mujer estarán más juntos, y el concepto de hombre podría estar más cerca de la palabra médico, por lo que el modelo heredará los sesgos de los datos de entrenamiento. Piense en los idiomas español o italiano, que tienen una versión masculina y femenina de la palabra enfermero (enfermero y enfermera). Si quieres traducir algo al español usando ese modelo entrenado, siempre usarás la versión femenina, lo cual es un sesgo. Sigue siendo solo matemática porque no sabe cuál es el concepto de mujer, hombre o enfermera, pero los datos que se utilizan para entrenar el modelo construyen ese sesgo.

[photo_footer]Catlett, durante su entrevista concedida a Evangelical Focus y World Magazine, en Wisla, en mayo de 2023./PD[/photo_footer]

P. ¿Cómo se puede apreciar este sesgo en Chat GPT y modelos de IA similares?

R. Open AI tiene Chat GPT (el modelo detrás es GPT-3 o GPT-4). Luego, Google tiene a Bard, Anthropic tiene a Claude y Microsoft coloca GPT-4 detrás de Bing. Se entrenan por separado con diferentes grandes cantidades de texto digital. Y debido a que la mejor fuente de texto digital o la mayor fuente de texto digital es Internet, como consecuencia tenemos modelos que se basan principalmente en datos que provienen del mundo occidental. Los lugares del mundo que no han tenido Internet durante 30 años todavía se están poniendo al día con su contenido, lo que significa que hay menos información que refleje la cultura o los valores de alguien de Ghana que de alguien de los Países Bajos o de California.

P. ¿Hay más gente hablando de la necesidad de entrenar estos modelos para obtener mejores resultados?

R. Sí, no soy de ninguna manera la única persona que habla de esto. Es útil pensar en algunos de los desafíos de la IA en tres categorías. Hay desafíos en la tecnología subyacente de la IA, por ejemplo, este concepto de “alucinación” donde, por alguna razón, estos grandes modelos de lenguaje inventan información que suena muy plausible pero que no es real, incluso referencias a artículos académicos que no existen.

[destacate]“La desinformación y la manipulación son preocupaciones inmediatas con el uso de la IA”[/destacate]Un segundo aspecto es cómo construimos sistemas funcionales de IA a partir de esa tecnología, donde los problemas incluyen la apertura sobre los datos de entrenamiento y los modelos que se utilizan. Por analogía, si el primer segmento es cómo extraemos el hierro del mineral, entonces este segundo segmento trata sobre los complementos que forjamos a partir de ese hierro.

Luego, en el tercer grupo, está la cuestión de cómo los usaremos, cómo tomaremos una herramienta como un modelo de lenguaje grande y la implementaremos en la sociedad o en sistemas como redes sociales o motores de búsqueda. Ya hemos visto el peligro de crear cámaras de eco donde la gente sólo ve las cosas con las que tiende a estar de acuerdo y no ve otros puntos de vista. Los temores que encontramos en la gente que trabaja con la IA, especialmente a corto plazo, se encuentran en ese tercer grupo: cosas como la desinformación o la manipulación.

P. Yuval Noah Harari dijo recientemente que la evolución de la IA podría poner en riesgo a la humanidad tal como la conocemos. Otros, como Future Of Life, piden regular urgentemente la IA para evitar resultados catastróficos. ¿Eres más optimista?

R. Creo que ahora debemos centrarnos en el corto plazo sin dejar de tener en cuenta el largo plazo. Harari y sus coautores, en el artículo del New York Times del 24 de marzo que mencionas, han señalado el poder de estos modelos. ¿Por qué? Hablan del lenguaje y de las palabras como el sistema operativo de las personas y de nuestra sociedad, y tienen toda la razón.

[destacate]“Debemos comprender mejor cómo funciona la IA para descubrir qué puede fallar”[/destacate]Nosotros, como cristianos, entendemos eso porque el lenguaje es la forma en que fuimos diseñados para comunicarnos unos con otros y comunicarnos con Dios. Por lo tanto, estamos programados para asumir que si algo nos habla con un lenguaje, debe tener intención y agencia y debe ser, en algún sentido, consciente. Somos susceptibles. Por eso la Biblia habla del peligro del chisme y la murmuración.

Creo que debemos comprender los peligros con un poco más de detalle. Una analogía que usaría es que no podemos comprar un aparato eléctrico que no haya sido certificado por un tercero como seguro. Por eso, cuando vamos a la tienda y enchufamos algo en casa, podemos estar seguros de que no nos electrocutaremos a menos que hagamos algo peligroso nosotros mismos, como enchufarlo mientras estamos dentro de la bañera. Pero una regulación se basa en la comprensión de cómo puede fallar la electricidad y hasta que comprendamos mejor cómo puede fallar la IA, es prematuro tener una reacción instintiva.

[photo_footer]Joel Forster y Charlie Catlett./PD[/photo_footer]

P. ¿Es irracional el miedo a la IA? ¿Es una realidad como la retratada en la película Terminator, donde una IA, Skynet, se convierte en una amenaza para la humanidad, un escenario potencial?

R. Creo que la primera y principal razón por la que no deberíamos tener miedo es que adoramos a un Dios que tiene el control del universo, y nada de lo que creemos será rival para ese Dios. No va a cambiar su voluntad soberana.

[destacate]“Ya se está usando IA para monitorear a la población”[/destacate]La Inteligencia Artificial es solo una herramienta que hemos desarrollado. Tiene la ilusión de ser una persona, pero es sólo una herramienta. No debemos tener miedo a la tecnología. Cuando alguien tiene miedo de una tecnología como esta, es muy útil pensar específicamente en qué es lo que crees que podría suceder y qué probabilidades hay de que suceda. Mencionaste “Skynet”, bueno, ahora mismo en ciertos países muy grandes el gobierno ya está usando IA para monitorear dónde está cada individuo en cualquier ciudad y usar eso para controlar los movimientos de su población. Entonces, eso ya es “Skynet” y se debe a que la IA la aplica una autoridad con ciertos valores.

El peligro es que ahora tenemos tecnología que un hombre fuerte como Mussolini o Hitler (o algunos candidatos que vemos hoy) podría tener mucho más poder en sus manos que sus predecesores incluso hace 10 años. La IA puede ser un facilitador para un hombre fuerte o un gobierno autoritario. La gente tiene miedo de ese control y vigilancia del poder, y creo que es legítimo que seamos conscientes de ello.

[destacate]“La IA no toma decisiones, no tiene esa capacidad”[/destacate]Creo que hay otro aspecto que es más ‘ciencia ficción’, por así decirlo, y es que la IA empezaría a tomar decisiones para tomar el control de nuestra sociedad. En este momento, incluso con los modelos más sofisticados que tenemos, no tenemos ningún tipo de IA que tenga ese tipo de capacidad de toma de decisiones. No tenemos IA que tengan opiniones, tienen prejuicios pero no opiniones. Y no están tomando decisiones.

De lo que los cristianos y otros deberían estar algo seguros, al menos en algún nivel, es que quienes construyen la tecnología también son conscientes de los peligros. Por cada artículo que he leído que dice: “Oye, hicimos esta prueba y parece que podría haber algo de inteligencia general allí”, también se presta mucha atención a cómo las cosas podrían salir mal.

P. Danos algunos ejemplos de fallos en la IA.

R. Si tengo un laboratorio controlado por GPT-4 y digo, “por favor hazme el medicamento contra la leucemia. Sal a buscar los materiales, pídelos y luego fabrica el medicamento con el laboratorio robótico”. Eso es genial, pero también puede hacerlo si le digo que produzca cierto riesgo biológico o material venenoso.

Otro ejemplo de algo que tienen en cuenta las personas que construyen sistemas de IA es el concepto de “alineación de objetivos”. Lo que eso significa es que cuando le pido al sistema de inteligencia artificial que haga algo, tengo que darle suficiente contexto. ¿Tiene suficiente información para perseguir y alcanzar ese objetivo sin hacer algo peligroso o inesperado? Imaginemos que tuviéramos un sistema de inteligencia artificial con el objetivo de llevar a estas 10 personas de este lado de la carretera a ese lado de la carretera, asegurándonos de que ninguno de ellos sea atropellado por un vehículo. Un enfoque válido sería catapultarlos al otro lado de la carretera, lo que tal vez dañaría gravemente a algunos de ellos. El objetivo se cumplió, pero hubo una ruta no intencionada hacia el objetivo porque el modelo GPT-4 realmente no entiende la vida real, simplemente hace lo que le dijimos que hiciera. Esta noción de “alineación de objetivos” es importante y hay una docena más de ellas.

Pero lo que quiero decir es que quienes construyen sistemas de inteligencia artificial son conscientes de estos peligros, y no estoy diciendo simplemente “confíen en los técnicos”, sino que al menos confíen en que están tratando de hacer que estas cosas sean seguras. Y cuando sentimos la necesidad de tener miedo, debemos ser muy específicos con nosotros mismos acerca de qué es lo que creemos que podría suceder porque muchas de esas cosas, como que la IA se apodere del mundo, todavía están en el ámbito de la ciencia ficción.

P. Los jóvenes que empiezan su carrera profesional en este momento de la historia podrían pensar: “¡dentro de 5 años, mi trabajo podría hacerlo una máquina!”. ¿Qué les dirías?

R. Los empleos y las carreras van y vienen a medida que se implementa cada tecnología. En los años 80, en Pittsburgh (Pensilvania) había estos tipos uniformados en los cruces, y su responsabilidad era presionar los botones para darte el paso. Bueno, ese trabajo ya no existe.

[destacate]“Hay trabajos que desaparecerán, pero se crearán otros ante nuevas necesidades”[/destacate]Llegó la World Wide Web y algunos puestos de trabajo desaparecieron: muchos agentes de viajes se quedaron sin trabajo porque la Web podía hacerlo. Muchos agentes de seguros o inmobiliarios tuvieron que cambiar su enfoque. Entonces, lo mismo va a pasar con la IA. Algunos puestos de trabajo desaparecerán en unos años, pero al menos se crearán otros tantos. Le daré solo un ejemplo: la calidad del resultado que obtiene de un modelo de lenguaje grande depende en gran medida del mensaje que le dé. Puedes dar indicaciones muy sofisticadas que no sólo hagan que el modelo te dé información, sino que también me la dé a mí en un estilo particular o desde una visión del mundo particular. Puedo hacer una sugerencia que diga algo como: “Usted es un maestro de escuela dominical bautista de 30 años, por favor explíqueme como si tuviera 5 años por qué es malo pegarle a mi vecino”. Y el modelo dará una respuesta que sonará como la de un maestro de escuela dominical de 30 años, no como la de un matón en la calle. Entonces, ha surgido un nuevo tipo de ocupación que es la de ingeniero puntual, alguien que sabe cómo impulsar estos modelos para obtener el tipo de resultado que estás buscando. Otro trabajo que va a explotar es el de las personas que seleccionan y administran los datos que utilizamos para entrenar esos modelos especialmente bien. No veo que la IA tenga efectos diferentes en los empleos que las tecnologías anteriores cuando aparecieron por primera vez.

[photo_footer]Una de las charlas que impartió Catlett para comunicadores estaba dedicada a analizar el estado actual de la IA.[/photo_footer]

P. La IA no es humana, pero parece que toma decisiones humanas...

R. No hay humanos involucrados en las interacciones del usuario con la IA. Cuando le preguntas a Chat GPT, “responde esta pregunta como una bailarina de ballet de Chicago”, no hay ningún ser humano ahí. El modelo de lenguaje grande ha captado patrones en los datos de entrenamiento sobre los tipos de cosas que un bailarín de ballet podría escribir o decir. Es solo que el modelo, cuando analiza todos estos datos, no solo recoge la información semántica sobre las palabras, sino que también recoge los patrones que representan estilos de escritura y estilos de respuesta.

Hay algunas preguntas que les hará a estos grandes modelos de lenguaje donde no hay una respuesta correcta, hay múltiples puntos de vista y, a menudo, obtendrá esos múltiples puntos de vista. Te dará una respuesta como, “bueno, algunas personas se sienten así y hay otra escuela de pensamiento que dice lo mismo”, y si vas más allá y dices, “¿qué crees que es mejor?”, probablemente estarás empujando para obtener una respuesta como: “Solo soy un modelo de lenguaje grande, no lo sé”.

[destacate]“Las empresas están invirtiendo mucho para que la IA no ofrezca respuestas tóxicas o sesgadas”[/destacate]Es muy caro entrenar estos modelos: el GPT-4 cuesta más de 100 millones de dólares. Por lo tanto, no van a seguir reentrenándolo desde cero, pero han introducido otro método llamado capa de seguridad para tratar de suavizar y eliminar algunos de los sesgos y el discurso tóxico que las personas experimentaron cuando apareció el chat GPT por primera vez. No había nada que impidiera que ese modelo de lenguaje grande respondiera preguntas como “mi vecino es de este origen étnico, dame un insulto realmente bueno para hacerlo sentir mal” y te daría ese insulto. Eso será algo en lo que todos estaríamos de acuerdo como discurso tóxico, pero entrenaron otro modelo para interpretar los resultados y descartar estas cosas tóxicas o extremadamente sesgadas. Esa es otra buena señal de que estas empresas reconocen ese peligro en particular y realmente han invertido en corregirlo. GPT es una experiencia completamente diferente hoy en día a la que era en noviembre de 2022, cuando decía cosas bastante escandalosas.

P. La tecnología está evolucionando muy rápido, parece como si alguien pudiera irse a dormir y despertarse en un mundo nuevo por la mañana.

R. Todo el tiempo suceden cosas nuevas en el campo en el que he estado durante 40 años, el de Internet y la informática de alto rendimiento. Estamos algo acostumbrados al cambio exponencial. Que las computadoras se vuelvan dos veces más rápidas cada 18 meses no se parece a nada que experimentemos día a día: mi automóvil no es el doble de rápido que hace 18 meses, y mi automóvil no cuesta ni una millonésima parte de lo que habría comprado en 2000. Pero por el mismo dinero hoy podemos comprar computadoras que son 10 millones de veces más rápidas que las que teníamos a principios de los años 1980. Hemos vivido en lo exponencial.

GPT-4 versus GPT-3 en noviembre pasado es sin duda cualitativa y cuantitativamente mejor. Es simplemente muy, muy sorprendente. Geoffrey Hinton, uno de los ganadores del Premio Turing en 2018 por su trabajo en aprendizaje profundo dijo que pensaba que para este nivel de inteligencia faltaba algunas décadas, lo que lo tomó por sorpresa. Nos tomó a todos por sorpresa.

P. ¿Cómo afecta la IA utilizada en las redes sociales a las personas vulnerables?

R. No hace mucho leí este artículo de Eric Schmidt en The Atlantic, donde realmente se centró en algo que a todos nos preocupa: el bienestar de nuestros jóvenes y adolescentes, y la prevalencia de la soledad y pensamientos suicidas. Las investigaciones ahora están comenzando a mostrarnos el impacto del uso de las redes sociales en la autoestima y la satisfacción con la vida. Un grupo de investigación estudió datos de encuestas de 84.000 personas y concluyó que entre las edades de 11 y 16 años, en términos generales, cuanto más usan los jóvenes las redes sociales, menos satisfacción en la vida reportan, y cuanto menos satisfacción tienen en la vida, más utilizan las redes sociales.

El Cirujano General de Estados Unidos, principal asesor médico del presidente, ha emitido una advertencia al respecto. No lo hacen muy a menudo. Aquí está sucediendo algo que todavía no entendemos del todo. El New York Times también publicó recientemente un vídeo de 15 minutos que examina lo que sabemos hasta ahora. Es una respuesta larga a tu pregunta, no tengo una respuesta fácil.

[photo_footer]Catlett sigue de cerca la actualidad y la evolución de la IA, al igual que muchos colegas en todo el mundo./PD[/photo_footer]

P. ¿Deberíamos esperar cambios tecnológicos más radicales en los próximos años?

R. Creo que hay una sensación de malestar porque no sabemos qué va a venir después. Creo que la bala de cañón que entró en la piscina y salpicó el agua, Chat GPT… No creo que haya otra de esas por venir muy pronto.

Una vez más, nadie puede predecir el futuro, pero creo que los cambios que hemos visto en los últimos seis meses no son una nueva normalidad. Veremos surgir cosas más notables, pero no creo que veamos este nivel de disrupción como un estado estable de ahora en adelante.

P. La vida eterna parece ser parte de las discusiones en torno a la IA, y algunos filósofos hablan de la esperanza de una “singularidad”. ¿Qué tiene que decir la cosmovisión cristiana al respecto?

R. Recientemente he estado pensando en la singularidad y las visiones del mundo generales a largo plazo, en el contexto de algunos como el Future of Life Institute, que estaban detrás de la idea de pausar la experimentación con IA durante seis meses. Realmente tienen una cosmovisión diferente en algunos aspectos específicos a la nuestra como cristianos. Estamos vagamente alineados con el objetivo de que no deberíamos destruir la Tierra y, por lo tanto, la humanidad, pero priorizarían la supervivencia de la humanidad sobre el bienestar de subconjuntos de la humanidad actual.

[destacate]“Nuestra esperanza cristiana se basa en la resurrección de Jesús”[/destacate]El objetivo del largoplacismo es la supervivencia de la raza humana, y cosas catastróficas como el cambio climático y la pobreza o la desnutrición son inconvenientes para la humanidad, pero no riesgos ni amenazas. Les darían menor prioridad, y nosotros como cristianos obviamente tendríamos una visión diferente, porque creemos que cada persona está hecha a imagen de Dios y por lo tanto tiene un valor infinito.

Entonces, la singularidad tiene incorporada esta noción de que podemos comenzar por mejorar con la tecnología. Aumentar nuestro cuerpo biológico con tecnología y, luego, en última instancia, poder tomar nuestra conciencia y cargarla en la tecnología para que podamos sobrevivir más allá de nuestro cuerpo biológico.

Esto es diferente de nuestra esperanza, que se basa en las palabras de Jesucristo, que resucitó de entre los muertos. Entonces, le doy más peso a sus palabras cuando dice: “Voy y os preparo un lugar”, cuando habla de que tengamos vida eterna. Más que las esperanzas de la tecnología futura, podremos mejorarnos con la IA durante nuestra vida. Si tuviéramos suficiente dinero, ¿pensaría que es una buena idea? Como cristiano, me preocupa porque implica que lo que Dios creó de alguna manera no es suficiente.

Dicho esto, hemos aumentado la humanidad con los viajes aéreos y otras cosas, por lo que no es algo realmente claro. Es algo de lo que tienes que llegar a estar convencido tú mismo. Pero la singularidad y la noción de “subirnos” a nosotros mismos a la nube digital, esa no es mi visión ni mi deseo para mi eternidad. Si yo fuera una persona que no tuviera esperanza en la eternidad y sintiera y creyera que todo esto es una existencia materialista, probablemente intentaría encontrar una manera de subirme a mí también. ¡Pero me gustaría saber en qué me estoy subiendo antes de hacer eso!

[donate]

La década en resumen: teología, con José Hutter

La década en resumen: teología, con José Hutter

La conmemoración de la Reforma, las tensiones en torno a la interpretación bíblica de la sexualidad o el crecimiento de las iglesias en Asia o África son algunos de los temas de la década que analizamos.

Intervalos: Disfruten de la luz

Intervalos: Disfruten de la luz

Estudiamos el fenómeno de la luz partiendo de varios detalles del milagro de la vista en Marcos 8:24, en el que Jesús nos ayuda a comprender nuestra necesidad de ver la realidad claramente.

2020, año del Brexit

2020, año del Brexit

Causas del triunfo de Boris Johnson y del Brexit; y sus consecuencias para la Unión Europea y la agenda globalista. Una entrevista a César Vidal.

7 Días 1x08: Irak, aborto el LatAm y el evangelio en el trabajo

7 Días 1x08: Irak, aborto el LatAm y el evangelio en el trabajo

Analizamos las noticias más relevantes de la semana.

Min19: Infancia, familia e iglesias

Min19: Infancia, familia e iglesias

Algunas imágenes del primer congreso protestante sobre ministerios con la infancia y la familia, celebrado en Madrid.

X Encuentro de Literatura Cristiana

X Encuentro de Literatura Cristiana

Algunas fotos de la entrega del Premio Jorge Borrow 2019 y de este encuentro de referencia, celebrado el sábado en la Facultad de Filología y en el Ayuntamiento de Salamanca. Fotos de MGala.

Idea2019, en fotos

Idea2019, en fotos

Instantáneas del fin de semana de la Alianza Evangélica Española en Murcia, donde se desarrolló el programa con el lema ‘El poder transformador de lo pequeño’.

Héroes: un padre extraordinario

Héroes: un padre extraordinario

José era alguien de una gran lealtad, la cual demostró con su actitud y acciones.

Programa especial de Navidad en TVE

Programa especial de Navidad en TVE

Celebración de Navidad evangélica, desde la Iglesia Evangélica Bautista Buen Pastor, en Madrid.

Primer Congreso sobre infancia y familia, primera ponencia

Primer Congreso sobre infancia y familia, primera ponencia

Madrid acoge el min19, donde ministerios evangélicos de toda España conversan sobre los desafíos de la infancia en el mundo actual.

Las opiniones vertidas por nuestros colaboradores se realizan a nivel personal, pudiendo coincidir o no con la postura de la dirección de Protestante Digital.

Si quieres comentar o